Likees 10-Minuten-Auto-Stummschaltung verstehen

Die 10-minütige Auto-Stummschaltung ist Likees erste Strafe für Richtlinienverstöße während Übertragungen. Im Gegensatz zu permanenten Sperren (1-20 Jahre) oder Shadowbans, die die Sichtbarkeit unterdrücken, schränken Auto-Stummschaltungen das Streaming vorübergehend ein, während der Kontozugriff erhalten bleibt. Diese abgestufte Durchsetzung nutzt KI-Erkennung, die verbotene Inhalte in Echtzeit identifiziert.

Likees Moderation bearbeitet monatlich etwa 8,7 Millionen Strafen. Zwischen Januar und Mai 2021 verhängte das System 42.751 Sperren. Die 10-minütige Stummschaltung dient als Bestrafung und Warnung, die Streamer dazu auffordert, Inhalte anzupassen, bevor es zu eskalierten Konsequenzen kommt.

Für unterbrechungsfreie Übertragungen bietet Likee Diamond Aufladung über BitTopup sicheren Zugang zu Premium-Funktionen, die die Stream-Qualität und die Zuschauerinteraktion verbessern.

Was ist eine Auto-Stummschaltung und wie unterscheidet sie sich von manuellen Sperren?

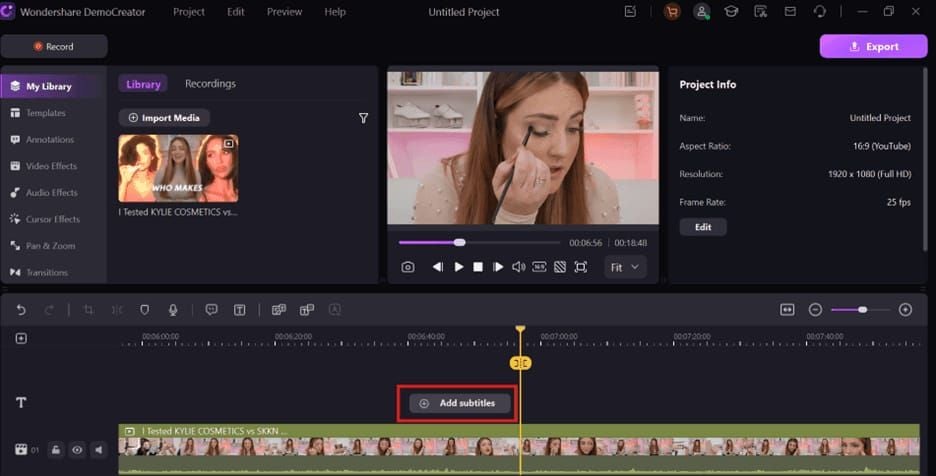

Auto-Stummschaltungen werden sofort aktiviert, wenn die KI verbotene Sprache erkennt, und deaktivieren Mikrofon und Chat für genau 10 Minuten. Ihr Stream sendet weiterhin Video, aber Zuschauer können weder Audio hören noch Textnachrichten sehen. Das System arbeitet unabhängig von menschlichen Moderatoren durch algorithmische Erkennung.

Manuelle Sperren erfordern menschliches Eingreifen bei schweren oder wiederholten Verstößen. Diese reichen von temporären Suspendierungen (125 USD Einspruchsgebühr) bis zu permanenten Sperren (175 USD Einspruchskosten). Shadowbans werden ausgelöst, wenn Streams innerhalb von 10 Minuten weniger als 41 Likes, null Aufrufe oder eine Wiedergabeabschlussrate unter 80 % erhalten. Shadowban-Einsprüche kosten 145 USD mit einer Bearbeitungszeit von 24-48 Stunden.

Auto-Stummschaltungen lösen sich nach 10 Minuten automatisch ohne Einspruch auf. Manuelle Sperren erfordern Dokumentation: Altersverifizierung, Telefonaufzeichnungen, Facebook-Bestätigung, Geburtsdatumsnachweis, Entschuldigungsschreiben und Compliance-Zusagen, die an feedback@likee.video gesendet werden.

Warum Likee automatische Moderation in US-Streams implementiert

US-Vorschriften für digitale Inhalte legen strengere Haftungsstandards fest, die eine aggressive Moderation erzwingen. Die Plattform gleicht die Freiheit der Ersteller mit den Anforderungen der Werbetreibenden, der Markensicherheit und der rechtlichen Compliance ab, die je nach Gerichtsbarkeit variieren.

Automatische Moderation skaliert die Durchsetzung über Millionen gleichzeitiger Streams hinweg, ohne dass der Personalbestand der Moderatoren proportional erhöht werden muss. Die KI wendet identische Standards an, unabhängig von der Popularität des Streamers, der Anzahl der Follower oder des Umsatzes, wodurch eine bevorzugte Behandlung verhindert und gleichzeitig werbefreundliche Umgebungen aufrechterhalten werden.

Die 10-minütige Dauer berücksichtigt versehentliche versus absichtliche Verstöße. Streamer, die versehentlich verbotene Begriffe verwenden, erhalten sofortiges Feedback ohne dauerhaften Schaden. Wiederholungstäter sammeln eine Historie von Verstößen an, die zu eskalierten Strafen führen, einschließlich permanenter Sperren von bis zu 20 Jahren für schwere Vergehen wie das Streamen von Minderjährigen.

Die Technologie hinter der Echtzeit-Spracherkennung

Likees KI kennzeichnet Verstöße innerhalb von 10 Minuten mithilfe von Speech-to-Text-Algorithmen, die Audio-Streams kontinuierlich verarbeiten. Die Technologie analysiert phonetische Muster, kontextuelle Verwendung und semantische Bedeutung, um verbotene Begriffe von akzeptablen Variationen zu unterscheiden, wodurch Fehlalarme reduziert und gleichzeitig eine schnelle Reaktion aufrechterhalten wird.

Das System pflegt ständig aktualisierte Datenbanken mit verbotenen Wörtern in mehreren Sprachen, regionalen Dialekten und Slang. Modelle des maschinellen Lernens werden anhand von Millionen gekennzeichneter Verstöße trainiert, wodurch die Genauigkeit durch Mustererkennung verbessert wird. Wenn die Erkennungssicherheit Schwellenwerte überschreitet, wird die Auto-Stummschaltung ohne menschliche Bestätigung aktiviert.

Die Verarbeitung erfolgt serverseitig, wodurch eine konsistente Durchsetzung unabhängig vom Standort des Streamers, Gerätetyp oder der Verbindungsqualität gewährleistet wird. Eine zentralisierte Architektur ermöglicht sofortige Richtlinienaktualisierungen über alle aktiven Streams hinweg, wodurch schnelle Reaktionen auf aufkommende Verstoßtrends ermöglicht werden.

Wie Likees KI verbotene Wörter während Live-Streams erkennt

Die Echtzeit-Erkennung beginnt, wenn Streamer Übertragungen aktivieren, wobei die kontinuierliche Audioüberwachung die Pipelines zur Verarbeitung natürlicher Sprache speist. Das System wandelt Sprache in Text um, analysiert die Struktur, identifiziert verbotene Begriffe, bewertet den Kontext und führt die Durchsetzung aus – alles innerhalb von Sekunden.

Speech-to-Text-Verarbeitung in Echtzeit

Fortschrittliche Spracherkennung wandelt Audio-Wellenformen mit über 95 % Genauigkeit für klare Sprache in Text um. Das System verarbeitet verschiedene Akzente, Sprechgeschwindigkeiten und Audioqualität, die beim mobilen Streaming üblich sind. Die Hintergrundgeräuschfilterung trennt Streamer-Stimmen von Musik, Zuschauer-Audio und Umgebungsgeräuschen.

Die Konvertierung erfolgt mit minimaler Latenz und verarbeitet Sprache innerhalb von 2-3 Sekunden nach der Äußerung. Dies ermöglicht eine nahezu sofortige Durchsetzung, während Streamer sich der Backend-Analyse nicht bewusst sind. Die Pufferung gewährleistet eine reibungslose Verarbeitung bei Netzwerkschwankungen.

Die Mehrsprachigkeit berücksichtigt kulturellen Kontext und regionale Variationen. Das System erkennt, dass identische phonetische Laute in verschiedenen Sprachen unterschiedliche Bedeutungen haben, wodurch Fehlalarme durch sprachübergreifende Homonyme verhindert werden.

Kontextanalyse: Wenn dasselbe Wort unterschiedlich behandelt wird

Eine ausgeklügelte Kontextanalyse unterscheidet verbotene Verwendung von akzeptablen Erwähnungen. Bildungsdiskussionen über Diskriminierung, Nachrichtenkommentare zu Gewalt oder künstlerischer Ausdruck, der Obszönitäten verwendet, werden anders behandelt als direkte Belästigung oder Hassrede. Die KI bewertet umgebende Wörter, Satzstruktur, Ton und Gesprächsfluss, um die Absicht zu beurteilen.

Dies erklärt, warum einige Streamer scheinbar verbotene Wörter verwenden, ohne Stummschaltungen auszulösen, während andere sofortige Strafen erhalten. Der Algorithmus berücksichtigt historische Verstoßmuster, aktuelle Themen, Zuschauerinteraktion und semantische Beziehungen. Gaming-Streamer, die über Gewalt im Spiel diskutieren, erhalten eine andere Analyse als direkte Drohungen.

Die Kontextanalyse bleibt unvollkommen und erzeugt gelegentlich Fehlalarme oder nicht erkannte Verstöße. Das System priorisiert eine übermäßige Durchsetzung, um die Exposition gegenüber schädlichen Inhalten zu minimieren, und akzeptiert einige ungerechtfertigte Stummschaltungen als Kompromiss für die Sicherheit der Gemeinschaft.

Mehrsprachige Erkennungsfunktionen

Likees Moderation verarbeitet Dutzende von Sprachen gleichzeitig und erkennt, dass US-Streamer häufig zwischen Englisch und ihren Herkunftssprachen wechseln. Die KI pflegt separate Datenbanken für verbotene Wörter für jede Sprache, während sie Begriffe, die in mehreren Kontexten vorkommen, querverweist.

Die Slang-Erkennung erweist sich als schwierig, da sich informelle Sprache schnell entwickelt und in verschiedenen regionalen Gemeinschaften variiert. Das System aktualisiert Slang-Datenbanken kontinuierlich basierend auf Verstoßberichten, Moderator-Feedback und linguistischer Trendanalyse. Beliebte Euphemismen, verschlüsselte Sprache und absichtliche Falschschreibungen erhalten durch Mustererkennung besondere Aufmerksamkeit.

Die Technologie befasst sich mit Transliterationsherausforderungen, bei denen Streamer englische Zeichen verwenden, die nicht-englische Wörter darstellen. Diese hybriden Ausdrücke erfordern eine phonetische Analyse in Kombination mit der Zeichenmustererkennung, um verbotene Inhalte zu identifizieren, die durch kreative Schreibweisen getarnt sind.

Vollständige Kategorien von Wörtern, die 10-Minuten-Stummschaltungen auslösen

Likees Rahmenwerk für verbotene Sprache unterteilt Verstöße in sechs Hauptkategorien, die jeweils Hunderte spezifischer Begriffe, Phrasen und kontextueller Ausdrücke enthalten. Für Ersteller, die in ihre Likee-Präsenz investieren, sorgt günstige Likee Diamonds aufladen bei BitTopup für den Zugang zu Premium-Funktionen, die die Stream-Produktion und das Zuschauerwachstum verbessern.

Kategorie 1: Obszönitäten und explizite Sprache

Gängige Obszönitäten lösen sofortige Auto-Stummschaltungen aus, unabhängig von Kontext oder Intensität. Das System kennzeichnet Standard-Schimpfwörter, sexuelle Anspielungen, beleidigend verwendete anatomische Begriffe und skatologische Ausdrücke. Schweregrade beeinflussen die 10-minütige Dauer nicht – milde Obszönitäten werden identisch behandelt wie extreme Vulgarität.

Kreative Schreibweisen wie das Ersetzen von Buchstaben durch Symbole oder Zahlen umgehen die Erkennung selten. Die KI erkennt Muster wie **f*ck,**sh!t oder a$$ als verbotene Variationen. Akronyme, die obszöne Wörter enthalten, lösen ebenfalls die Durchsetzung aus.

Vermeiden Sie:

- Standard-Obszönitäten in jeder Sprache

- Sexuellen Slang und Anspielungen

- Beleidigend verwendete anatomische Referenzen

- Skatologische Begriffe und Toilettenhumor

- Obszöne Akronyme und Abkürzungen

- Kreative Falschschreibungen, die Filter umgehen sollen

Kategorie 2: Hassrede und diskriminierende Begriffe

Die Durchsetzung von Hassrede stellt Likees strengste Moderation dar, mit null Toleranz für Beleidigungen, diskriminierende Sprache oder abfällige Begriffe, die geschützte Merkmale betreffen. Das System kennzeichnet rassistische Beleidigungen, ethnische Beschimpfungen, religiöse Verhöhnung, homophobe Sprache, transphobe Ausdrücke, ableistische Begriffe und altersbedingte Diskriminierung.

Der Kontext bietet minimalen Schutz. Selbst Bildungsdiskussionen oder die Wiederaneignung durch Community-Mitglieder lösen aufgrund der Schwierigkeit, die Absicht algorithmisch zu unterscheiden, oft Auto-Stummschaltungen aus. Streamer, die soziale Gerechtigkeitsthemen diskutieren, sollten klinische Terminologie verwenden, anstatt beleidigende Sprache zu wiederholen, die sie kritisieren.

Die KI erkennt auch verschlüsselte Hassrede, einschließlich Dog Whistles, numerische Referenzen zu extremistischen Ideologien und scheinbar unschuldige Phrasen mit dokumentierter diskriminierender Verwendung.

Kategorie 3: Belästigung und Mobbing-Phrasen

Direkte Angriffe auf Personen – ob Zuschauer, andere Streamer oder Persönlichkeiten des öffentlichen Lebens – lösen Strafen wegen Belästigung aus. Das System identifiziert bedrohliche Sprache, Einschüchterungstaktiken, Doxing-Versuche, Ermutigung zur Selbstverletzung, Hinweise auf anhaltenden unerwünschten Kontakt und Indikatoren für koordinierte Belästigung.

Die Mobbing-Erkennung umfasst:

- Wiederholte negative Kommentare zum Aussehen

- Spott über Sprechmuster oder Behinderungen

- Ermutigung des Publikums zu kollektiven Angriffen auf Einzelpersonen

- Weitergabe persönlicher Informationen ohne Zustimmung

- Als Witze getarnte Drohungen

- Anhaltende Kritik, die darauf abzielt, zu demütigen

Die KI gewichtet Wiederholungsmuster, wobei einzelne negative Kommentare anders behandelt werden als anhaltende Kampagnen. Streamer, die wiederholt dieselbe Person in mehreren Übertragungen angreifen, sehen sich eskalierten Strafen gegenüber, die über die standardmäßigen 10-Minuten-Stummschaltungen hinausgehen.

Kategorie 4: Referenzen zu Inhalten für Erwachsene

Einschränkungen für sexuelle Inhalte verbieten explizite Diskussionen, Anbahnungen, Pornografie-Referenzen, Erwähnungen von Escort-Diensten und sexuell anzügliche Sprache, die über leichtes Flirten hinausgeht. Das System unterscheidet altersgerechte romantische Inhalte von explizitem sexuellem Material, obwohl die Grenzen für Werbetreibende konservativ bleiben.

Verbotene Inhalte für Erwachsene:

- Explizite Beschreibungen sexueller Handlungen

- Anbahnung sexueller Dienstleistungen

- Referenzen zu Pornografie-Websites oder Darstellern

- Sexuelle Rollenspielszenarien

- Grafische anatomische Diskussionen

- Links zu Plattformen für Erwachsene

Altersverifizierungsanforderungen verschärfen die Einschränkungen. Streamer müssen mindestens 18 Jahre alt sein, um zu senden, wobei Konten für Benutzer zwischen 16 und 17 Jahren nur zum Ansehen berechtigt sind. Benutzer unter 16 Jahren werden von der Plattform gesperrt, und Verstöße gegen Altersbeschränkungen führen zu Sperren von bis zu 20 Jahren.

Kategorie 5: Gewalt- und Bedrohungsindikatoren

Gewaltbezogene Verstöße umfassen direkte Drohungen, grafische Gewaltbeschreibungen, Inhalte zur Selbstverletzung, die Förderung gefährlicher Herausforderungen, die Verherrlichung von Waffen und Anweisungen für schädliche Aktivitäten. Das System unterscheidet Diskussionen über fiktive Gewalt (wie Videospielinhalte) von der Befürwortung realer Gewalt.

Gaming-Streamer, die über Kämpfe im Spiel diskutieren, vermeiden in der Regel Verstöße, indem sie einen klaren fiktiven Kontext beibehalten. Der Übergang von der Spieldiskussion zur Befürwortung realer Gewalt löst jedoch sofortige Durchsetzung aus. Die KI überwacht diese Kontextverschiebungen.

Spezifische Drohungen werden am strengsten durchgesetzt, insbesondere wenn sie sich an identifizierbare Personen oder Gruppen richten. Selbst hypothetische oder scherzhafte Drohungen lösen Auto-Stummschaltungen aus, da es schwierig ist, die Ernsthaftigkeit und mögliche reale Konsequenzen algorithmisch zu beurteilen.

Kategorie 6: Erwähnungen illegaler Aktivitäten

Hinweise auf illegale Aktivitäten, einschließlich Drogenhandel, Waffenhandel, Betrugssysteme, Piraterie, Hacking und andere kriminelle Unternehmen, lösen sofortige Durchsetzung aus. Das System kennzeichnet sowohl direkte Beteiligungsansprüche als auch Anweisungsinhalte, die illegale Aktivitäten erleichtern.

Die KI unterscheidet Nachrichtenberichte über illegale Aktivitäten von deren Förderung oder Beteiligung. Streamer, die über aktuelle Ereignisse mit Verbrechen berichten, vermeiden in der Regel Verstöße, indem sie eine journalistische Rahmung beibehalten und Verherrlichung vermeiden. Das Teilen persönlicher Erfahrungen mit illegalen Aktivitäten oder das Bereitstellen von Anleitungen überschreitet jedoch die Durchsetzungsschwellen.

Verbotene Themen:

- Koordination von Drogenkauf oder -verkauf

- Förderung von gefälschten Produkten

- Erklärungen zu Betrugssystemen

- Hacking-Tutorials oder -Dienste

- Verbreitung von raubkopierten Inhalten

- Strategien zur Steuerhinterziehung

- Methoden des Identitätsdiebstahls

US-spezifische Likee Stream-Sperrregeln und regionale Unterschiede

Die amerikanische Inhaltsmoderation unterliegt aufgrund regulatorischer Umgebungen, Erwartungen von Werbetreibenden und kulturellen Normen strengeren Standards als viele internationale Märkte. US-Streamer sehen sich einer aggressiveren Durchsetzung bestimmter Verstoßkategorien gegenüber.

Warum US-Moderationsstandards strenger sind

US-Rechtsrahmen legen die Plattformhaftung für nutzergenerierte Inhalte in bestimmten Kontexten fest, insbesondere in Bezug auf Kindersicherheit, Hassrede und gewalttätige Inhalte. Abschnitt 230-Schutz bietet eine gewisse Immunität, eliminiert aber nicht alle rechtlichen Risiken, was konservative Moderationsrichtlinien erzwingt, die die minimalen gesetzlichen Anforderungen übertreffen.

Die Standards der Werbetreibenden in amerikanischen Märkten erfordern markensichere Umgebungen mit minimalen kontroversen Inhalten. Große Marken lehnen die Zusammenarbeit mit Plattformen ab, die unmoderierte Hassrede, explizite Inhalte oder gewalttätiges Material hosten. Dieser wirtschaftliche Druck treibt eine strengere Durchsetzung über die gesetzliche Compliance hinaus voran, da der Umsatzverlust durch den Exodus von Werbetreibenden die Kosten für aggressive Moderation übersteigt.

Kulturelle Erwartungen an akzeptable öffentliche Sprache variieren erheblich zwischen US-Märkten und Regionen mit unterschiedlichen Normen der freien Meinungsäußerung. Während einige internationale Märkte Obszönitäten in Rundfunkmedien tolerieren, halten amerikanische werbefinanzierte Plattformen konservative Standards ein, die eher dem Mainstream-Fernsehen als den Normen der Internetkultur entsprechen.

Einhaltung der US-Vorschriften für digitale Inhalte

Der Children's Online Privacy Protection Act (COPPA) schreibt strenge Altersverifizierung und Inhaltsbeschränkungen für Benutzer unter 13 Jahren vor, was Likees 16+-Kontoanforderung und die 18+-Streaming-Schwelle beeinflusst. Verstöße gegen Altersbeschränkungen lösen die schwerwiegendsten Strafen der Plattform aus, mit Sperren von bis zu 20 Jahren für das Streamen von Minderjährigen.

Aufkommende staatliche Vorschriften zur Rechenschaftspflicht digitaler Plattformen, insbesondere in Kalifornien, New York und Texas, schaffen eine komplexe Compliance, die konservative landesweite Richtlinien erfordert. Anstatt staatsspezifische Moderationsvariationen zu implementieren, wendet Likee die strengsten Standards einheitlich auf alle US-Benutzer an.

Richtlinien der Federal Trade Commission zu irreführenden Praktiken, Offenlegung von Empfehlungen und Verbraucherschutz erstrecken sich auf Live-Streaming-Kontexte. Streamer, die Produkte ohne ordnungsgemäße Offenlegung bewerben oder falsche Behauptungen aufstellen, sehen sich Verstößen gegenüber, die über die Standard-Inhaltsbeschränkungen hinausgehen, obwohl diese in der Regel eine manuelle Überprüfung und keine automatischen Stummschaltungen auslösen.

Wörter, die in den USA verboten, aber in anderen Regionen erlaubt sind

Bestimmte Obszönitäten, die in europäischen oder asiatischen Märkten akzeptabel sind, lösen in US-Streams aufgrund kultureller Empfindlichkeitsunterschiede eine automatische Durchsetzung aus. Britische englische Obszönitäten, die im britischen Kontext als mild gelten, werden in amerikanischen Streams streng durchgesetzt, wo identische Begriffe stärkere beleidigende Konnotationen haben.

Einschränkungen der politischen Rede variieren erheblich zwischen den Regionen. Hinweise auf kontroverse politische Persönlichkeiten, Bewegungen oder Ideologien, die in einigen internationalen Märkten Toleranz erfahren, lösen in US-Streams eine Durchsetzung aus, wenn sie in die Bereiche Hassrede oder Belästigung übergehen. Die KI wendet regionsspezifische politische Kontextdatenbanken an, um Verstoßschwellen zu bewerten.

Regionaler Slang schafft Durchsetzungsunterschiede, wo Begriffe mit unschuldigen Bedeutungen in einigen englischsprachigen Ländern in amerikanischen Kontexten beleidigende Konnotationen haben. Das System priorisiert US-kulturelle Interpretationen für Streams, die von amerikanischen IP-Adressen stammen, was gelegentlich zu Verwirrung bei internationalen Streamern führt, die US-Publikum ansprechen.

Kontextsensitive Phrasen: Wenn unschuldige Wörter Stummschaltungen auslösen

Fehlalarme bei Auto-Stummschaltungen frustrieren konforme Streamer, wenn legitime Inhalte versehentlich Durchsetzungsalgorithmen auslösen. Das Verständnis gängiger Fehlalarmmuster hilft, unbeabsichtigte Verstöße zu vermeiden und gleichzeitig eine natürliche Kommunikation aufrechtzuerhalten.

Häufige Fehlalarme, die von Streamern gemeldet werden

Gaming-Terminologie erzeugt häufig Fehlalarme, wenn kompetitive Sprache verbotene Belästigungs- oder Gewaltkategorien nachahmt. Phrasen wie **den Feind zerstören,**Killstreak oder die Konkurrenz dominieren lösen gelegentlich eine Durchsetzung aus, wenn die Kontextanalyse die spielspezifische Verwendung nicht erkennt.

Bildungsinhalte, die verbotene Themen zur Sensibilisierung oder Prävention diskutieren, lösen manchmal Auto-Stummschaltungen aus, obwohl die Absicht positiv ist. Streamer, die Cybermobbing, Diskriminierungsbewusstsein oder Sicherheitsthemen behandeln, müssen Diskussionen sorgfältig gestalten, um die schädliche Sprache, die sie kritisieren, nicht zu wiederholen.

Medizinische und anatomische Terminologie, die in Gesundheitsdiskussionen verwendet wird, löst gelegentlich Filter für Inhalte für Erwachsene aus, wenn Algorithmen klinische Sprache als sexuelle Referenzen missinterpretieren. Fitness-Streamer, Gesundheitserzieher und Ersteller von Wellness-Inhalten stehen vor besonderen Herausforderungen, diese Grenze zu navigieren.

Wie Likees Algorithmus den Gesprächskontext bewertet

Die KI analysiert Satzstruktur, umgebendes Vokabular, den Verlauf des Gesprächsthemas und Interaktionsmuster des Publikums, um zu beurteilen, ob potenziell verbotene Begriffe gegen Richtlinien verstoßen. Bildungsrahmen, klinische Terminologie und ein klarer fiktiver Kontext bieten einen gewissen Schutz, obwohl ein unvollkommenes algorithmisches Verständnis gelegentlich Fehler erzeugt.

Die Tonanalyse versucht, aggressive von spielerischer Verwendung grenzwertiger Sprache zu unterscheiden. Sarkasmus, Ironie und Humor erweisen sich jedoch für die KI-Interpretation als schwierig, was manchmal zu Stummschaltungen für Witze führt, die menschliche Moderatoren als akzeptabel erkennen würden. Das System neigt zur Durchsetzung, wenn der Ton zweideutig bleibt.

Historische Verstoßmuster beeinflussen aktuelle Durchsetzungsentscheidungen. Streamer mit einer sauberen Compliance-Historie erhalten eine geringfügig nachsichtigere Kontextinterpretation als Ersteller mit mehreren früheren Verstößen. Diese Reputationsbewertung schafft Anreize für langfristige Compliance, benachteiligt aber möglicherweise neue Streamer, die die Plattformnormen lernen.

Gaming-Terminologie, die Warnungen auslösen kann

Die Sprache des kompetitiven Gamings enthält zahlreiche Phrasen, die verbotenen Inhalten ähneln, wenn sie aus dem Gaming-Kontext entfernt werden. Seien Sie vorsichtig mit:

- Tötungs-Referenzen (verwenden Sie eliminieren oder besiegen)

- Zerstören von Gegnern (verwenden Sie ausspielen oder gewinnen gegen)

- Trash Talk, der in persönliche Angriffe übergeht

- Wutausbrüche, die Obszönitäten enthalten

- Teamkoordinationssprache, die Gewaltplanung ähnelt

- Siegesfeiern, die besiegte Gegner verspotten

Ego-Shooter- und Battle-Royale-Streamer stehen aufgrund der inhärent gewalttätigen Spielmechanik vor besonderen Herausforderungen. Die Aufrechterhaltung eines klaren Gaming-Kontexts durch konsistente spielspezifische Terminologie und die Vermeidung von Übergängen zu Diskussionen über reale Gewalt minimiert das Risiko von Fehlalarmen.

Strategie-Spiel-Streamer, die über **aggressive Expansion,**feindliche Übernahmen oder Feinde zerschlagen diskutieren, sollten einen klaren spielspezifischen Rahmen beibehalten, um Kontextverwirrung zu vermeiden. Die Verwendung spielspezifischer Terminologie anstelle generischer gewalttätiger Sprache hilft Algorithmen, Inhalte korrekt zu kategorisieren.

Was passiert tatsächlich während einer 10-Minuten-Stummschaltung

Das Verständnis der praktischen Auswirkungen von Auto-Stummschaltungen hilft Streamern, Notfallmaßnahmen vorzubereiten und Störungen des Publikums bei Verstößen zu minimieren.

Streamer-Funktionen und Einschränkungen während der Stummschaltung

Während aktiver Stummschaltungen wird Ihr Mikrofon automatisch deaktiviert, wodurch die Audioübertragung an die Zuschauer verhindert wird. Auch die Chat-Funktionen werden ausgesetzt, wodurch die Kommunikation über Textnachrichten blockiert wird. Das Video wird jedoch normal weiter übertragen, sodass die Zuschauer Reaktionen und visuelle Inhalte sehen können.

Sie behalten den Zugriff auf Stream-Steuerelemente, einschließlich des Beendens von Übertragungen, des Anpassen von Kameraeinstellungen und des Anzeigens eingehender Zuschauernachrichten. Diese teilweise Funktionalität ermöglicht die Schadensbegrenzung durch visuelle Kommunikation – das Hochhalten von Schildern, die Verwendung von Gesten oder das Anzeigen vorbereiteter Grafiken, die technische Schwierigkeiten erklären.

Die Stummschaltungsbenachrichtigung erscheint nur auf Ihrem Streamer-Dashboard, nicht für die Zuschauer. Das Publikum sieht einen plötzlichen Audioverlust ohne Erklärung, es sei denn, Sie haben visuelle Kommunikationsmethoden vorbereitet. Viele Zuschauer gehen von technischen Schwierigkeiten und nicht von Richtlinienverstößen aus, was einen gewissen Reputationsschutz bei versehentlichen Verstößen bietet.

Wie Zuschauer Ihren stummgeschalteten Stream erleben

Zuschauer erleben einen abrupten Audioabbruch mitten im Satz, wenn Auto-Stummschaltungen aktiviert werden, typischerweise begleitet von Verwirrung darüber, ob das Problem von ihrem Gerät, ihrer Verbindung oder Ihrem Stream herrührt. Ohne sichtbare Stummschaltungsbenachrichtigungen aktualisieren die Zuschauer oft Streams, überprüfen Audioeinstellungen oder hinterlassen Kommentare, die nach technischen Problemen fragen.

Das Video läuft normal weiter, wodurch eine Diskrepanz zwischen visuellen Inhalten, die Sie sprechen zeigen, und fehlendem Audio entsteht. Engagierte Zuschauer warten möglicherweise mehrere Minuten auf eine Lösung, während Gelegenheitszuschauer in der Regel abbrechen, um funktionierende Streams zu finden. Dieser Zuschauerverlust wirkt sich auf die Anzahl der gleichzeitigen Zuschauer, Engagement-Metriken und algorithmische Sichtbarkeitsrankings aus.

Zuschauerkommentare während der Stummschaltungen enthalten oft Vorschläge zur technischen Fehlerbehebung, Fragen zu Audioproblemen und schließlich Spekulationen über Richtlinienverstöße. Erfahrene Likee-Benutzer, die mit Auto-Stummschaltungssystemen vertraut sind, können andere Zuschauer über die wahrscheinliche Ursache informieren, was selbst bei versehentlichen Verstößen den Ruf schädigen kann.

Auswirkungen auf Stream-Metriken und Sichtbarkeitsrankings

Auto-Stummschaltungen lösen eine sofortige Verschlechterung der Metriken aus, da verwirrte Zuschauer abbrechen. Die Anzahl der gleichzeitigen Zuschauer sinkt stark, die Abschlussraten der Wiedergabezeit nehmen ab und die Engagement-Metriken leiden unter der Unfähigkeit, auf Kommentare zu antworten. Diese Auswirkungen auf die Metriken gehen über die 10-minütige Stummschaltungsdauer hinaus und beeinflussen algorithmische Empfehlungen für Stunden oder Tage danach.

Likees Empfehlungsalgorithmus priorisiert Streams mit starken Engagement-Metriken, konsistenter Zuschauerbindung und positiven Zuschauerinteraktionen. Plötzliche Metrikabstürze während der Stummschaltungen signalisieren dem Algorithmus Qualitätsprobleme, wodurch die Sichtbarkeit des Streams in Entdeckungsfunktionen, Empfehlungsfeeds und Trendkategorien reduziert wird.

Mehrere Stummschaltungen innerhalb kurzer Zeiträume verstärken den Metrikschaden und bauen gleichzeitig eine Verstoßhistorie auf, die zukünftige Durchsetzungsentscheidungen beeinflusst. Das System verfolgt die Häufigkeit, Schwere und Muster von Verstößen, um Wiederholungstäter zu identifizieren, die eskalierte Strafen erfordern. Drei oder mehr Stummschaltungen innerhalb eines einzelnen Streams lösen oft eine manuelle Überprüfung für potenzielle temporäre oder permanente Sperren aus.

Shadowban-Auslöser sind auch mit der durch Stummschaltungen verursachten Metrikverschlechterung verbunden. Streams, die innerhalb von 10 Minuten weniger als 41 Likes, null Aufrufe oder Wiedergabeabschlussraten unter 80 % erhalten, sehen sich Shadowban-Strafen gegenüber, die die Sichtbarkeit ohne Benachrichtigung unterdrücken. Auto-Stummschaltungen, die Ihre Metriken abstürzen lassen, können unbeabsichtigt diese sekundären Strafen auslösen, wodurch sich die Durchsetzungseffekte verstärken.

14 bewährte Strategien zur Vermeidung von Auto-Stummschaltungen bei Likee-Streams

Proaktive Compliance-Strategien minimieren das Risiko von Verstößen und erhalten gleichzeitig ansprechende, authentische Inhalte, die beim Publikum Anklang finden.

Vorbereitung vor dem Stream: Chat-Filter einrichten

Konfigurieren Sie Likees integrierte Chat-Filter, bevor Sie live gehen, um verbotene Wörter aus den Kommentaren der Zuschauer automatisch zu blockieren. Dies verhindert, dass Sie während der Zuschauerinteraktion versehentlich markierte Begriffe lesen und wiederholen. Greifen Sie über Ihr Streamer-Dashboard unter den Moderationstools auf die Filtereinstellungen zu.

Erstellen Sie benutzerdefinierte Listen mit verbotenen Wörtern, die speziell auf Ihre Inhaltsnische und Zielgruppendemografie zugeschnitten sind. Gaming-Streamer sollten kompetitives Trash Talk, das Belästigungsgrenzen überschreitet, einbeziehen, während Lifestyle-Streamer sich auf beleidigende Äußerungen zum Aussehen und Body-Shaming-Sprache konzentrieren könnten.

Testen Sie die Filterkonfigurationen während privater Streams, um sicherzustellen, dass sie die beabsichtigten Begriffe blockieren, ohne übermäßige Fehlalarme zu erzeugen, die die legitime Zuschauerkommunikation frustrieren. Balancieren Sie den Schutz mit einer nicht übermäßigen Moderation, die das Zuschauerengagement nicht unterdrückt.

Echtzeit-Überwachungstechniken

Benennen Sie einen vertrauenswürdigen Moderator, der Ihren Stream mit einer Verzögerung von 10-15 Sekunden überwacht und Echtzeitwarnungen gibt, wenn die Sprache an die Grenzen von Verstößen stößt. Diese externe Perspektive fängt riskante Phrasen auf, die Sie während energiegeladener Übertragungen möglicherweise übersehen.

Verwenden Sie sekundäre Geräte, um Ihren eigenen Stream so zu überwachen, wie Zuschauer ihn erleben, um Audio-Probleme, Kontextprobleme oder grenzwertige Sprache zu erkennen, bevor Verstöße auftreten. Dieser Dual-Screen-Ansatz bietet sofortiges Feedback darüber, wie Inhalte auf das Zuschauererlebnis übertragen werden.

Entwickeln Sie ein persönliches Bewusstsein für Hochrisikomomente:

- Hitzige kompetitive Gaming-Sequenzen

- Diskussionen über kontroverse Themen

- Zuschauer-Q&A-Sitzungen mit unvorhersehbaren Fragen

- Kollaborations-Streams mit Gästen, die mit Likee-Richtlinien nicht vertraut sind

- Spätabend-Streams, wenn Müdigkeit die Selbstüberwachung reduziert

Ihr Publikum in Community-Richtlinien schulen

Informieren Sie die Zuschauer während der Stream-Einführungen über Likees Community-Standards, insbesondere wenn Sie neue Zuschauer anziehen, die mit den Plattformregeln nicht vertraut sind. Erklären Sie, dass bestimmte Sprachen automatische Durchsetzung auslösen, die das Erlebnis aller beeinträchtigt, und schaffen Sie so eine gemeinsame Verantwortung für die Einhaltung.

Pinnen Sie Nachrichten im Chat an, die die Zuschauer an verbotene Inhalte erinnern und sie bitten, zur Aufrechterhaltung konformer Umgebungen beizutragen. Gestalten Sie Richtlinien positiv als Community-Werte und nicht als restriktive Regeln, um eine kollaborative Compliance-Kultur zu fördern.

Erkennen und danken Sie Zuschauern, die bei der Chat-Moderation helfen, indem sie Verstöße melden oder andere an Richtlinien erinnern. Diese positive Verstärkung fördert die Selbstregulierung der Community, reduziert Ihre Moderationslast und stärkt die Investition des Publikums in den Stream-Erfolg.

Effektiver Einsatz von Moderationstools

Ernennen Sie mehrere vertrauenswürdige Moderatoren in verschiedenen Zeitzonen, um die Abdeckung während aller Streaming-Stunden zu gewährleisten. Geben Sie klare Richtlinien, wann Nachrichten gelöscht, Benutzer gesperrt oder Sie auf potenzielle Verstöße aufmerksam gemacht werden sollen, die eine sofortige Reaktion erfordern.

Gewähren Sie Moderatoren entsprechende Berechtigungen, einschließlich Nachrichtenlöschung, Benutzersperren und Bann-Funktionen für schwere oder wiederholte Verstöße. Behalten Sie jedoch die Befugnis für permanente Sperren für sich selbst, um Missbrauch durch Moderatoren oder übereifrige Durchsetzung zu verhindern.

Führen Sie regelmäßige Moderatorenschulungen durch, in denen aktuelle Richtlinienaktualisierungen überprüft, herausfordernde Moderationsszenarien diskutiert und die Durchsetzungsstandards abgestimmt werden. Eine konsistente Moderation schafft vorhersehbare Umgebungen, in denen Zuschauer Grenzen und Konsequenzen verstehen.

Alternative Phrasen für häufige riskante Wörter

Entwickeln Sie Vokabular-Substitutionen für risikoreiche Begriffe, die in Ihrer Inhaltsnische üblich sind:

Anstelle von Obszönitäten:

- Verdammt oder Mist ersetzt stärkere Schimpfwörter

- Oh mein Gott anstelle religiöser Obszönitäten

- Was zum Teufel für überraschte Reaktionen

- Verflixt als Intensitätsmodifikator

Anstelle von gewalttätiger Gaming-Sprache:

- Eliminiert statt getötet

- Besiegt statt zerstört

- Ausgespielt ersetzt dominiert

- Den Sieg gesichert versus sie zerschmettert

Anstelle von potenziell beleidigendem Slang:

- Spezifische beschreibende Sprache ersetzt vage Beleidigungen

- Spielspezifische Terminologie anstelle von generischem Trash Talk

- Positive Formulierung, die Ihre Fähigkeiten über die Schwäche des Gegners hervorhebt

Üben Sie diese Substitutionen, bis sie zu natürlichen Sprachmustern werden, wodurch die kognitive Belastung in energiegeladenen Streaming-Momenten reduziert wird, in denen die Selbstüberwachung am schwierigsten ist.

Häufige Missverständnisse über Likee Stream-Sperren

Die Klärung weit verbreiteter Missverständnisse hilft Streamern, fundierte Compliance-Entscheidungen auf der Grundlage genauer Plattformkenntnisse und nicht auf Community-Mythen zu treffen.

Mythos: Die Verwendung von Symbolen zum Ersetzen von Buchstaben umgeht die Erkennung

Die KI erkennt gängige Symbolsubstitutionen, einschließlich Sternchen, Zahlen und Sonderzeichen, die Buchstaben in verbotenen Wörtern ersetzen. Muster wie **f*ck,****sh!t,**a$$ oder b!tch lösen die gleiche Durchsetzung aus wie unveränderte Begriffe. Die Mustererkennungsalgorithmen des Systems identifizieren phonetische Ähnlichkeiten und gängige Umgehungstechniken.

Fortgeschrittene Variationen mit Unicode-Zeichen, Emoji-Kombinationen oder kreativen Abständen werden ebenfalls erkannt. Die Technologie wird kontinuierlich aktualisiert, um aufkommende Umgehungsmuster zu erkennen, wenn Streamer neue Umgehungsversuche entwickeln. Das Verlassen auf Symbolsubstitutionen schafft eine falsche Sicherheit, die oft zu unerwarteten Verstößen führt.

Der einzig zuverlässige Ansatz besteht darin, verbotene Begriffe vollständig zu eliminieren, anstatt kreative Verkleidungen zu versuchen. Vokabularsubstitution mit wirklich anderen Wörtern bietet tatsächlichen Schutz gegenüber kosmetischen Änderungen an markierter Sprache.

Mythos: Schnelles Sprechen verhindert die KI-Erkennung

Die Speech-to-Text-Verarbeitung verarbeitet verschiedene Sprechgeschwindigkeiten mit konsistenter Genauigkeit. Schnelles Sprechen kann geringfügige Transkriptionsfehler verursachen, aber verbotene Wörter bleiben auch bei unvollständiger Transkription erkennbar. Die Fehlertoleranz der KI berücksichtigt Nuscheln, Akzente und Geschwindigkeitsvariationen.

Schnelles Sprechen bei der Verwendung verbotener Sprache verstärkt oft Verstöße, indem es absichtlich ausweichend erscheint. Das System kann schnell aufeinanderfolgende Obszönitäten als absichtliche Umgehung der Richtlinien interpretieren, was möglicherweise eine manuelle Überprüfung und eskalierte Strafen über die standardmäßigen Auto-Stummschaltungen hinaus auslöst.

Klares, moderat schnelles Sprechen bietet besseren Schutz, indem es eine genaue Transkription akzeptabler Sprache gewährleistet. Wenn die KI konforme Inhalte sicher erkennt, ist es weniger wahrscheinlich, dass sie grenzwertige Phrasen kennzeichnet, die unter unsicheren Transkriptionsbedingungen eine Durchsetzung auslösen könnten.

Mythos: Private Streams haben keine Moderation

Alle Likee-Streams unterliegen der gleichen automatisierten Moderation, unabhängig von den Datenschutzeinstellungen oder der Zuschauerzahl. Private Streams, die auf genehmigte Follower beschränkt sind, unterliegen der gleichen KI-Erkennung, den gleichen Durchsetzungsschwellen und Strafstrukturen wie öffentliche Übertragungen. Das 10-minütige Auto-Stummschalten wird identisch aktiviert, egal ob Sie an 5 Zuschauer oder 5.000 streamen.

Diese universelle Durchsetzung verhindert, dass Streamer private Streams nutzen, um Verstöße zu koordinieren, verbotene Inhalte mit ausgewählten Zielgruppen zu teilen oder richtlinienwidrige Inhalte zu üben. Das System unterscheidet nicht zwischen öffentlichen und privaten Kontexten bei der Bewertung der Einhaltung der Community-Richtlinien.

Verstoßhistorien aus privaten Streams wirken sich identisch auf den Kontostatus aus wie Verstöße aus öffentlichen Streams. Mehrere Verstöße in privaten Streams tragen zu Eskalationsmustern bei, die manuelle Überprüfungen und potenzielle permanente Sperren auslösen.

Wahrheit: Wie wiederholte Verstöße Strafen eskalieren

Die Plattform verfolgt die Häufigkeit, Schwere und Muster von Verstößen über die gesamte Streaming-Historie hinweg. Während einzelne Auto-Stummschaltungen unabhängig von der Anzahl der Verstöße genau 10 Minuten dauern, lösen angesammelte Verstöße eskalierende Konsequenzen aus, einschließlich manueller Überprüfungen, temporärer Suspendierungen und permanenter Sperren.

Spezifische Eskalationsschwellen bleiben unveröffentlicht, um eine Manipulation des Systems zu verhindern, aber Streamer berichten von manuellen Überprüfungen nach 3-5 Verstößen innerhalb von 30-Tage-Perioden. Diese Überprüfungen bewerten, ob Verstöße versehentliche Vergehen oder absichtliche Missachtung der Richtlinien darstellen, und bestimmen die entsprechenden eskalierten Strafen.

Permanente Sperren von 1-20 Jahren werden möglich, nachdem Muster wiederholter Verstöße trotz früherer Warnungen festgestellt wurden. Die schwerwiegendsten 20-Jahres-Sperren gelten typischerweise für schwerwiegende Verstöße wie das Streamen von Minderjährigen, schwere Hassrede oder koordinierte Belästigungskampagnen. Einspruchsverfahren für permanente Sperren kosten 175 USD mit einer Bearbeitungszeit von 24-48 Stunden und erfordern umfassende Dokumentation, einschließlich Altersverifizierung, Entschuldigungsschreiben und Compliance-Zusagen.

Wiederherstellung und Einspruchsverfahren nach Erhalt von Stummschaltungen

Das Verständnis der Verfahren nach einem Verstoß hilft Streamern, langfristige Schäden zu minimieren und den Kontostatus nach Verstößen wiederherzustellen.

Wie sich mehrere Stummschaltungen auf Ihren Kontostatus auswirken

Jede Auto-Stummschaltung erstellt einen permanenten Eintrag in der Kontohistorie, der zur Analyse von Verstoßmustern beiträgt, die zukünftige Durchsetzungsentscheidungen beeinflussen. Das System gewichtet neuere Verstöße stärker als historische Vergehen, wobei Verstöße, die älter als 90 Tage sind, eine geringere Auswirkung auf den aktuellen Status haben.

Die Verstoßdichte ist wichtiger als die absolute Anzahl. Fünf Verstöße, die sich über sechs Monate verteilen, werden anders behandelt als fünf Verstöße innerhalb einer Woche. Konzentrierte Verstoßmuster deuten auf absichtliche Missachtung der Richtlinien oder unzureichende Compliance-Bemühungen hin, was aggressivere Durchsetzungsmaßnahmen auslöst.

Der Kontostatus wirkt sich über die Durchsetzung hinaus aus:

- Reduzierte Sichtbarkeit in Empfehlungsalgorithmen

- Geringere Priorität in Entdeckungsfunktionen

- Verringerte Berechtigung für Plattform-Promotions

- Potenzieller Ausschluss aus Monetarisierungsprogrammen

- Reduzierte Glaubwürdigkeit bei Partnerschaftsmöglichkeiten

Schritt-für-Schritt-Anleitung zum Einspruch gegen ungerechtfertigte Auto-Stummschaltungen

Während 10-minütige Auto-Stummschaltungen automatisch ohne Einspruch gelöst werden, hilft die Dokumentation ungerechtfertigter Durchsetzung, Muster für eskalierte Einsprüche zu etablieren, wenn sich Verstöße ansammeln:

- Sofortigen Zeitpunkt und Kontext des Verstoßes aufzeichnen – Notieren Sie genau, was Sie gesagt haben, das umgebende Gespräch und warum Sie glauben, dass die Durchsetzung fehlerhaft war

- Wenn möglich, Videoaufnahmen machen – Bildschirmaufnahmen, die den Moment des Verstoßes zeigen, liefern konkrete Beweise für Einspruchsüberprüfungen

- Die Auto-Stummschaltungsbenachrichtigung dokumentieren – Screenshot des Streamer-Dashboards, der die Durchsetzungsmaßnahme und den angegebenen Grund zeigt

- Den tatsächlichen Verstoß mit den Community-Richtlinien abgleichen – Ehrlich beurteilen, ob der Inhalt tatsächlich gegen Richtlinien verstoßen hat oder einen algorithmischen Fehler darstellt

- Detaillierte Einsprüche an feedback@likee.video senden – Fügen Sie Zeitstempel, Kontexterklärungen, Videobeweise und spezifische Richtlinieninterpretationen bei, die Ihre Position unterstützen

- Compliance während der Einspruchsbearbeitung aufrechterhalten – Zusätzliche Verstöße während der Einspruchsüberprüfungen schädigen die Glaubwürdigkeit erheblich und verringern die Wahrscheinlichkeit einer Aufhebung

Die Bearbeitung von Einsprüchen für schwerwiegende Strafen dauert 24-48 Stunden, wobei die Kosten zwischen 125 USD für temporäre Sperren und 175 USD für permanente Sperren liegen. Shadowban-Einsprüche kosten 145 USD. Einzelne 10-minütige Auto-Stummschaltungen rechtfertigen jedoch in der Regel keine kostenpflichtigen Einsprüche, es sei denn, sie tragen zu eskalierten Strafen bei.

Wiederherstellung Ihrer Streamer-Reputationspunktzahl

Konsequente Compliance über längere Zeiträume stellt den durch frühere Verstöße beschädigten Kontostatus allmählich wieder her. Die Reputationsalgorithmen der Plattform gewichten das jüngste Verhalten stärker, sodass Streamer sich von frühen Fehlern durch nachhaltige Richtlinieneinhaltung erholen können.

Wiederherstellungsstrategien:

- 90+ aufeinanderfolgende Tage ohne Verstöße streamen

- Starke positive Engagement-Metriken generieren, die qualitativ hochwertige Inhalte signalisieren

- Publikumsgemeinschaften mit geringen Moderationsanforderungen aufbauen

- An Plattforminitiativen und Creator-Programmen teilnehmen

- Richtlinienkenntnisse durch Community-Führung demonstrieren

Proaktive Compliance-Schulungen signalisieren Engagement für Plattformstandards. Streamer, die öffentlich über Community-Richtlinien diskutieren, anderen Erstellern helfen, Richtlinien zu verstehen, und positive Community-Kulturen fördern, erhalten algorithmische Vorteile, die historische Verstoßauswirkungen teilweise ausgleichen.

Erwägen Sie nach mehreren Verstößen vorübergehende Streaming-Pausen, um Muster zurückzusetzen und Inhalte mit neuem Compliance-Fokus anzugehen. Das Fortsetzen des Streamings, während man über die Durchsetzung frustriert ist, führt oft zu zusätzlichen Verstößen, die den Reputationsschaden verstärken.

Häufig gestellte Fragen

Welche Wörter lösen automatische Stummschaltungen bei Likee Live-Streams aus?

Likees KI kennzeichnet Obszönitäten, Hassrede, diskriminierende Begriffe, Belästigungsphrasen, Referenzen zu Inhalten für Erwachsene, Gewalt-Sprache und Erwähnungen illegaler Aktivitäten. Das System pflegt Datenbanken mit Hunderten spezifischer verbotener Wörter in mehreren Sprachen, wobei die Kontextanalyse bestimmt, ob grenzwertige Begriffe gegen Richtlinien verstoßen. Kreative Schreibweisen mit Symbolen oder Zahlen erhalten die gleiche Durchsetzung wie unveränderte verbotene Wörter.

Wie lange dauert eine Likee Stream-Stummschaltung?

Auto-Stummschaltungen dauern genau 10 Minuten ab der Aktivierung. Ihr Mikrofon und Ihre Chat-Funktionen werden automatisch deaktiviert, während das Video normal weiter übertragen wird. Die Stummschaltung löst sich automatisch auf, ohne dass Einsprüche oder manuelle Eingriffe erforderlich sind. Mehrere Stummschaltungen innerhalb kurzer Zeiträume lösen jedoch manuelle Überprüfungen aus, die zu temporären Suspendierungen oder permanenten Sperren von 1-20 Jahren führen können.

Kann man gegen eine Likee Auto-Stummschaltungsstrafe Einspruch einlegen?

Einzelne 10-minütige Auto-Stummschaltungen erfordern keine Einsprüche, da sie sich automatisch auflösen. Wenn jedoch angesammelte Verstöße zu eskalierten Strafen wie temporären oder permanenten Sperren führen, können Sie über feedback@likee.video Einspruch einlegen. Einsprüche gegen temporäre Sperren kosten 125 USD, Einsprüche gegen permanente Sperren kosten 175 USD und Shadowban-Einsprüche kosten 145 USD. Die Bearbeitung dauert 24-48 Stunden und erfordert Altersverifizierungsdokumente, Entschuldigungsschreiben und Compliance-Zusagen.

Sperrt Likee einen dauerhaft, wenn man Schimpfwörter sagt?

Einzelne Obszönitätsverstöße lösen 10-minütige Auto-Stummschaltungen aus und keine permanenten Sperren. Wiederholte Verstöße etablieren jedoch Muster, die zu temporären Suspendierungen und schließlich zu permanenten Sperren von 1-20 Jahren eskalieren. Die Plattform verhängte zwischen Januar und Mai 2021 42.751 Sperren, wobei die schwerwiegendsten 20-Jahres-Sperren typischerweise für schwerwiegende Verstöße wie das Streamen von Minderjährigen, schwere Hassrede oder koordinierte Belästigungskampagnen reserviert sind.

Wie erkennt Likee verbotene Wörter in Echtzeit?

Likees KI wandelt Sprache während Übertragungen kontinuierlich in Text um und analysiert phonetische Muster, kontextuelle Verwendung und semantische Bedeutung. Das System kennzeichnet Verstöße innerhalb von 10 Minuten nach dem Auftreten und verarbeitet die Sprache typischerweise innerhalb von 2-3 Sekunden nach der Äußerung. Mehrsprachige Unterstützung, Slang-Erkennung und Kontextanalyse helfen, verbotene Verwendung von akzeptablen Erwähnungen zu unterscheiden, obwohl unvollkommene Algorithmen gelegentlich Fehlalarme erzeugen.

Was passiert mit Zuschauern, wenn ein Streamer stummgeschaltet wird?

Zuschauer erleben einen plötzlichen Audioabbruch ohne sichtbare Benachrichtigungen, die die Ursache erklären. Das Video wird normal weiter übertragen, was zu Verwirrung führt, da sie Sie sprechen sehen, aber kein Audio hören. Die meisten Zuschauer gehen von technischen Schwierigkeiten aus, wobei viele Streams aktualisieren oder Audioeinstellungen überprüfen. Etwa 30-50 % der Zuschauer verlassen stummgeschaltete Streams typischerweise innerhalb von 2-3 Minuten, was die Engagement-Metriken und algorithmischen Sichtbarkeitsrankings erheblich beeinträchtigt.

Halten Sie Ihre Likee-Streaming-Karriere am Laufen! Laden Sie Ihre Likee Diamonds sicher und sofort bei BitTopup auf, um Premium-Funktionen freizuschalten, die Sichtbarkeit zu erhöhen und Ihr Publikum ohne Unterbrechungen zu begeistern. Besuchen Sie BitTopup jetzt für exklusive Angebote für Likee-Aufladungen!