Înțelegerea Sistemului de Auto-Mutare de 10 Minute al Likee

Auto-mutarea de 10 minute este prima penalizare aplicată de Likee pentru încălcările ghidurilor în timpul transmisiunilor. Spre deoseosebire de interdicțiile permanente (1-20 de ani) sau shadowban-urile care suprimă vizibilitatea, auto-mutările restricționează temporar streamingul, permițând în același timp accesul la cont. Această aplicare graduală utilizează detectarea AI care identifică conținutul interzis în timp real.

Moderarea Likee gestionează aproximativ 8,7 milioane de penalizări lunar. Între ianuarie și mai 2021, sistemul a emis 42.751 de interdicții. Mutarea de 10 minute servește ca pedeapsă și avertisment, semnalând streamerilor să-și ajusteze conținutul înainte de consecințe escalate.

Pentru transmisiuni neîntrerupte, reîncărcarea de diamante Likee prin BitTopup oferă acces securizat la funcții premium care îmbunătățesc calitatea streamului și interacțiunea cu publicul.

Ce Este o Auto-Mutare și Cum Diferă de Interdicțiile Manuale

Auto-mutările se activează imediat când AI detectează limbaj interzis, dezactivând microfonul și chatul pentru exact 10 minute. Streamul tău continuă să transmită video, dar spectatorii nu pot auzi audio sau vedea mesaje text. Sistemul operează independent de moderatorii umani prin detectare algoritmică.

Interdicțiile manuale necesită intervenția umană pentru încălcări grave sau repetate. Acestea variază de la suspendări temporare (taxă de apel de 125 USD) la interdicții permanente (cost de apel de 175 USD). Shadowban-urile se declanșează atunci când streamurile primesc mai puțin de 41 de aprecieri în 10 minute, zero vizualizări sau o rată de finalizare a vizionării sub 80%. Apelurile pentru shadowban costă 145 USD, cu o procesare de 24-48 de ore.

Auto-mutările se rezolvă automat după 10 minute, fără a necesita apeluri. Interdicțiile manuale necesită documentație: verificare a vârstei, înregistrări telefonice, confirmare Facebook, dovadă a datei de naștere, scrisori de scuze și angajamente de conformitate trimise la feedback@likee.video.

De Ce Likee Implementează Moderarea Automată în Streamurile din SUA

Reglementările privind conținutul digital din SUA impun standarde de răspundere mai stricte, impunând o moderare agresivă. Platforma echilibrează libertatea creatorilor cu cerințele agențiilor de publicitate, siguranța brandului și conformitatea legală, care variază în funcție de jurisdicție.

Moderarea automată extinde aplicarea legii la milioane de streamuri concurente fără o creștere proporțională a personalului de moderatori. AI aplică standarde identice indiferent de popularitatea streamerului, numărul de urmăritori sau venituri, prevenind tratamentul preferențial și menținând în același timp medii prietenoase cu agențiile de publicitate.

Durata de 10 minute abordează încălcările accidentale versus cele intenționate. Streamerii care folosesc din greșeală termeni interziși primesc feedback imediat fără daune permanente. Infractorii recidiviști acumulează istorice de încălcări care declanșează penalități escalate, inclusiv interdicții permanente de până la 20 de ani pentru infracțiuni grave, cum ar fi streamingul de către minori.

Tehnologia din Spatele Detectării Limbajului în Timp Real

AI-ul Likee semnalează încălcările în 10 minute folosind algoritmi de recunoaștere vocală care procesează continuu fluxurile audio. Tehnologia analizează modele fonetice, utilizarea contextuală și semnificația semantică pentru a diferenția termenii interziși de variațiile acceptabile, reducând falsurile pozitive și menținând un răspuns rapid.

Sistemul menține baze de date actualizate constant cu cuvinte interzise în mai multe limbi, dialecte regionale și argou. Modelele de învățare automată se antrenează pe milioane de încălcări semnalate, îmbunătățind acuratețea prin recunoașterea modelelor. Când încrederea în detectare depășește pragurile, auto-mutarea se activează fără confirmare umană.

Procesarea are loc pe server, asigurând o aplicare consecventă indiferent de locația streamerului, tipul de dispozitiv sau calitatea conexiunii. Arhitectura centralizată permite actualizări instantanee ale politicilor pe toate streamurile active, permițând răspunsuri rapide la tendințele emergente de încălcare.

Cum Detectează AI-ul Likee Cuvintele Interzise în Timpul Transmisiunilor Live

Detectarea în timp real începe atunci când streamerii activează transmisiunile, cu monitorizarea audio continuă care alimentează conductele de procesare a limbajului natural. Sistemul convertește vorbirea în text, analizează structura, identifică termenii interziși, evaluează contextul și execută aplicarea legii – totul în câteva secunde.

Procesarea Vorbirii în Text în Timp Real

Recunoașterea vocală avansată convertește undele sonore în text cu o precizie de peste 95% pentru vorbirea clară. Sistemul gestionează diverse accente, viteze de vorbire și calități audio comune în streamingul mobil. Filtrarea zgomotului de fundal separă vocile streamerilor de muzică, audio-ul spectatorilor și sunetele ambientale.

Conversia operează cu o latență minimă, procesând vorbirea în 2-3 secunde de la rostire. Acest lucru permite o aplicare aproape instantanee, în timp ce streamerii rămân inconștienți de analiza din spate. Bufferingul asigură o procesare fluidă în timpul fluctuațiilor de rețea.

Suportul multilingv încorporează contextul cultural și variațiile regionale. Sistemul recunoaște că sunetele fonetice identice au semnificații diferite în diverse limbi, prevenind falsurile pozitive de la omonimele interlingvistice.

Analiza Contextului: Când Același Cuvânt Primește Tratamente Diferite

Analiza contextuală sofisticată diferențiază utilizarea interzisă de mențiunile acceptabile. Discuțiile educaționale despre discriminare, comentariile de știri despre violență sau expresia artistică folosind blasfemii primesc un tratament diferit față de hărțuirea directă sau discursul instigator la ură. AI evaluează cuvintele înconjurătoare, structura propoziției, tonul și fluxul conversației pentru a evalua intenția.

Acest lucru explică de ce unii streameri folosesc cuvinte aparent interzise fără a declanșa mutări, în timp ce alții se confruntă cu penalități imediate. Algoritmul cântărește modelele istorice de încălcare, subiectele curente, interacțiunea cu publicul și relațiile semantice. Streamerii de jocuri care discută despre violența din joc primesc o analiză diferită față de amenințările directe.

Analiza contextului rămâne imperfectă, generând ocazional falsuri pozitive sau falsuri negative. Sistemul prioritizează supra-aplicarea pentru a minimiza expunerea la conținut dăunător, acceptând unele mutări greșite ca un compromis pentru siguranța comunității.

Capacități de Detectare Multilingvă

Moderarea Likee procesează zeci de limbi simultan, recunoscând că streamerii din SUA comută frecvent între engleză și limbile de origine. AI menține baze de date separate de cuvinte interzise pentru fiecare limbă, în timp ce verifică termenii care apar în mai multe contexte.

Detectarea argoului se dovedește dificilă, deoarece limbajul informal evoluează rapid și variază în funcție de comunitățile regionale. Sistemul actualizează continuu bazele de date de argou pe baza rapoartelor de încălcare, feedback-ului moderatorilor și analizei tendințelor lingvistice. Eufemismele populare, limbajul codificat și greșelile de scriere intenționate primesc o atenție specială prin potrivirea modelelor.

Tehnologia abordează provocările transliterării, unde streamerii folosesc caractere englezești care reprezintă cuvinte non-engleze. Aceste expresii hibride necesită analiză fonetică combinată cu recunoașterea modelelor de caractere pentru a identifica conținutul interzis deghizat prin ortografie creativă.

Categorii Complete de Cuvinte Care Declanșează Mutări de 10 Minute

Cadrul de limbaj interzis al Likee împarte încălcările în șase categorii principale, fiecare conținând sute de termeni specifici, fraze și expresii contextuale. Pentru creatorii care investesc în prezența Likee, reîncărcarea ieftină de diamante Likee la BitTopup asigură accesul la funcții premium care îmbunătățesc producția streamului și creșterea audienței.

Categoria 1: Blasfemie și Limbaj Explicit

Blasfemia comună declanșează auto-mutări imediate, indiferent de context sau intensitate. Sistemul semnalează cuvinte vulgare standard, referințe sexuale, termeni anatomici folosiți ofensator și expresii scatologice. Nivelurile de gravitate nu afectează durata de 10 minute – blasfemia ușoară primește un tratament identic cu vulgaritatea extremă.

Variațiile creative de scriere, cum ar fi înlocuirea literelor cu simboluri sau numere, rareori ocolesc detectarea. AI recunoaște modele precum **f*ck,**sh!t, sau a$$ ca variații interzise. Acronimele care conțin cuvinte profane declanșează, de asemenea, aplicarea legii.

Evitați:

- Blasfemia standard în orice limbă

- Argoul sexual și insinuările

- Referințele anatomice folosite insultător

- Termenii scatologici și umorul de toaletă

- Acronimele și abrevierile profane

- Greșelile de scriere creative concepute pentru a ocoli filtrele

Categoria 2: Discurs Instigator la Ură și Termeni Discriminatori

Aplicarea legii privind discursul instigator la ură reprezintă cea mai strictă moderare a Likee, cu toleranță zero pentru insulte, limbaj discriminatoriu sau termeni derogatorii care vizează caracteristici protejate. Sistemul semnalează insultele rasiale, insultele etnice, batjocura religioasă, limbajul homofob, expresiile transfobe, termenii abilisti și discriminarea bazată pe vârstă.

Contextul oferă o protecție minimă. Chiar și discuțiile educaționale sau utilizarea recuperată de către membrii comunității declanșează adesea auto-mutări din cauza dificultății de a distinge algoritmic intenția. Streamerii care discută subiecte de justiție socială ar trebui să folosească terminologie clinică, mai degrabă decât să repete limbajul ofensator pe care îl critică.

AI detectează, de asemenea, discursul instigator la ură codificat, inclusiv "dog whistles", referințe numerice la ideologii extremiste și fraze aparent inocente cu utilizare discriminatorie documentată.

Categoria 3: Hărțuire și Fraze de Bullying

Atacurile directe asupra persoanelor – fie spectatori, alți streameri sau personalități publice – declanșează penalități de hărțuire. Sistemul identifică limbajul amenințător, tacticile de intimidare, încercările de doxxing, încurajarea auto-vătămării, referințele persistente la contacte nedorite și indicatorii de hărțuire coordonată.

Detectarea bullyingului include:

- Comentarii negative repetate despre aspect

- Batjocorirea modelelor de vorbire sau a dizabilităților

- Încurajarea atacurilor în masă ale publicului împotriva persoanelor

- Partajarea informațiilor personale fără consimțământ

- Făcerea de amenințări deghizate în glume

- Critici susținute menite să umilească

AI cântărește modelele de repetare, comentariile negative singulare primind un tratament diferit față de campaniile susținute. Streamerii care vizează în mod repetat aceeași persoană în mai multe transmisiuni se confruntă cu penalități escalate dincolo de mutările standard de 10 minute.

Categoria 4: Referințe la Conținut pentru Adulți

Restricțiile privind conținutul sexual interzic discuțiile explicite, solicitarea, referințele la pornografie, mențiunile serviciilor de escortă și limbajul sexual sugestiv dincolo de flirtul ușor. Sistemul distinge conținutul romantic adecvat vârstei de materialul sexual explicit, deși limitele rămân conservatoare pentru standardele agențiilor de publicitate.

Conținut pentru adulți interzis:

- Descrieri explicite ale actelor sexuale

- Solicitarea de servicii sexuale

- Referințe la site-uri web sau artiști pornografici

- Scenarii de joc de rol sexual

- Discuții anatomice grafice

- Linkuri către platforme de conținut pentru adulți

Cerințele de verificare a vârstei complică restricțiile. Streamerii trebuie să aibă peste 18 ani pentru a transmite, iar conturile pentru utilizatorii de 16-17 ani sunt limitate doar la vizionare. Utilizatorii sub 16 ani se confruntă cu blocaje de platformă, iar încălcările restricțiilor de vârstă duc la interdicții de până la 20 de ani.

Categoria 5: Violență și Indicatori de Amenințare

Încălcările legate de violență cuprind amenințări directe, descrieri grafice ale violenței, conținut de auto-vătămare, promovarea provocărilor periculoase, glorificarea armelor și instrucțiuni pentru activități dăunătoare. Sistemul diferențiază discuțiile despre violența ficțională (cum ar fi conținutul jocurilor video) de promovarea violenței din lumea reală.

Streamerii de jocuri care discută despre luptele din joc evită de obicei încălcările menținând un context ficțional clar. Cu toate acestea, trecerea de la discuțiile despre joc la promovarea violenței din lumea reală declanșează aplicarea imediată. AI monitorizează aceste schimbări contextuale.

Limbajul specific de amenințare primește cea mai strictă aplicare, în special atunci când este direcționat către persoane sau grupuri identificabile. Chiar și formatele de amenințare ipotetice sau glumețe declanșează auto-mutări din cauza dificultății de a evalua algoritmic sinceritatea și potențialele consecințe în lumea reală.

Categoria 6: Mențiuni de Activitate Ilegală

Referințele la activități ilegale, inclusiv vânzări de droguri, trafic de arme, scheme de fraudă, piraterie, hacking și alte întreprinderi criminale, declanșează aplicarea imediată. Sistemul semnalează atât afirmațiile de participare directă, cât și conținutul instructiv care facilitează activități ilegale.

AI distinge discuțiile de știri despre activități ilegale de promovare sau participare. Streamerii care acoperă evenimente curente care implică infracțiuni evită de obicei încălcările menținând un cadru jurnalistic și evitând glorificarea. Cu toate acestea, partajarea experiențelor personale cu activități ilegale sau furnizarea de instrucțiuni depășește pragurile de aplicare.

Subiecte interzise:

- Coordonarea achizițiilor sau vânzărilor de droguri

- Promovarea produselor contrafăcute

- Explicații ale schemelor de fraudă

- Tutoriale sau servicii de hacking

- Distribuția de conținut piratat

- Strategii de evaziune fiscală

- Metode de furt de identitate

Reguli de Interdicție a Streamurilor Likee Specifice SUA și Diferențe Regionale

Moderarea conținutului american operează sub standarde mai stricte decât multe piețe internaționale din cauza mediilor de reglementare, așteptărilor agențiilor de publicitate și normelor culturale. Streamerii din SUA se confruntă cu o aplicare mai agresivă a anumitor categorii de încălcări.

De Ce Standardele de Moderare din SUA Sunt Mai Stricte

Cadrele legale din SUA impun răspunderea platformei pentru conținutul generat de utilizatori în contexte specifice, în special în ceea ce privește siguranța copiilor, discursul instigator la ură și conținutul violent. Protecțiile Secțiunii 230 oferă o anumită imunitate, dar nu elimină toate riscurile legale, impunând politici de moderare conservatoare care depășesc cerințele legale minime.

Standardele agențiilor de publicitate pe piețele americane cer medii sigure pentru branduri, cu un conținut controversat minim. Brandurile majore refuză asocierea cu platforme care găzduiesc discurs instigator la ură nemoderat, conținut explicit sau material violent. Această presiune economică determină o aplicare mai strictă dincolo de conformitatea legală, deoarece pierderea de venituri din exodul agențiilor de publicitate depășește costurile de moderare agresivă.

Așteptările culturale privind discursul public acceptabil variază semnificativ între piețele din SUA și regiunile cu norme diferite de liberă exprimare. În timp ce unele piețe internaționale tolerează blasfemia în mass-media, platformele americane susținute de agenții de publicitate mențin standarde conservatoare aliniate cu televiziunea mainstream, mai degrabă decât cu normele culturii internetului.

Conformitatea cu Reglementările SUA privind Conținutul Digital

Legea privind protecția confidențialității online a copiilor (COPPA) impune verificarea strictă a vârstei și restricții de conținut pentru utilizatorii sub 13 ani, influențând cerința Likee de conturi pentru 16+ și pragul de streaming pentru 18+. Încălcările restricțiilor de vârstă declanșează cele mai severe penalități ale platformei, cu interdicții de până la 20 de ani pentru streamingul de către minori.

Reglementările emergente la nivel de stat privind responsabilitatea platformelor digitale, în special în California, New York și Texas, creează o complexitate de conformitate care necesită politici naționale conservatoare. În loc să implementeze variații de moderare specifice statului, Likee aplică cele mai stricte standarde uniform tuturor utilizatorilor din SUA.

Ghidurile Comisiei Federale pentru Comerț privind practicile înșelătoare, dezvăluirile de aprobare și protecția consumatorilor se extind la contextele de streaming live. Streamerii care promovează produse fără dezvăluiri adecvate sau fac afirmații false se confruntă cu încălcări dincolo de restricțiile standard de conținut, deși acestea declanșează de obicei o revizuire manuală, mai degrabă decât mutări automate.

Cuvinte Interzise în SUA, Dar Permise în Alte Regiuni

Anumite blasfemii acceptabile pe piețele europene sau asiatice declanșează aplicarea automată în streamurile din SUA din cauza diferențelor de sensibilitate culturală. Blasfemia engleză britanică considerată ușoară în contextele din Marea Britanie primește o aplicare strictă în streamurile americane, unde termeni identici au conotații ofensive mai puternice.

Restricțiile privind discursul politic variază semnificativ în funcție de regiune. Referințele la figuri politice controversate, mișcări sau ideologii care primesc toleranță pe unele piețe internaționale declanșează aplicarea în streamurile din SUA atunci când trec în teritoriile discursului instigator la ură sau hărțuirii. AI aplică baze de date de context politic specifice regiunii pentru a evalua pragurile de încălcare.

Argoul regional creează disparități de aplicare, unde termeni cu semnificații inocente în unele țări vorbitoare de engleză au conotații ofensive în contextele americane. Sistemul prioritizează interpretările culturale din SUA pentru streamurile provenite de la adrese IP americane, creând ocazional confuzie pentru streamerii internaționali care accesează publicul din SUA.

Fraze Sensibile la Context: Când Cuvinte Inocente Declanșează Mutări

Auto-mutările false pozitive îi frustrează pe streamerii conformi atunci când conținutul legitim declanșează accidental algoritmii de aplicare. Înțelegerea modelelor comune de falsuri pozitive ajută la evitarea încălcărilor neintenționate, menținând în același timp o comunicare naturală.

Falsuri Pozitive Comune Raportate de Streameri

Terminologia de jocuri generează frecvent falsuri pozitive atunci când limbajul competitiv imită hărțuirea sau categoriile de violență interzise. Fraze precum **distruge inamicul,**serie de ucideri sau domină competiția declanșează ocazional aplicarea legii atunci când analiza contextului nu reușește să recunoască utilizarea specifică jocurilor.

Conținutul educațional care discută subiecte interzise pentru conștientizare sau prevenire declanșează uneori auto-mutări, în ciuda intenției pozitive. Streamerii care abordează cyberbullyingul, conștientizarea discriminării sau subiectele de siguranță trebuie să încadreze cu atenție discuțiile pentru a evita repetarea limbajului dăunător pe care îl critică.

Terminologia medicală și anatomică utilizată în discuțiile despre sănătate declanșează ocazional filtre de conținut pentru adulți atunci când algoritmii interpretează greșit limbajul clinic ca referințe sexuale. Streamerii de fitness, educatorii în sănătate și creatorii de conținut de wellness se confruntă cu provocări deosebite în navigarea acestei limite.

Cum Evaluează Algoritmul Likee Contextul Conversațional

AI analizează structura propoziției, vocabularul înconjurător, istoricul subiectului conversației și modelele de interacțiune cu publicul pentru a evalua dacă termenii potențial interziși încalcă ghidurile. Încadrarea educațională, terminologia clinică și contextul ficțional clar oferă o anumită protecție, deși înțelegerea algoritmică imperfectă generează erori ocazionale.

Analiza tonului încearcă să distingă utilizarea agresivă de cea jucăușă a limbajului de graniță. Cu toate acestea, sarcasmul, ironia și umorul se dovedesc dificile pentru interpretarea AI, rezultând uneori în mutări pentru glume pe care moderatorii umani le-ar recunoaște ca acceptabile. Sistemul greșește spre aplicare atunci când tonul rămâne ambiguu.

Modelele istorice de încălcare influențează deciziile curente de aplicare. Streamerii cu istorice de conformitate curate primesc o interpretare contextuală marginal mai indulgentă decât creatorii cu multiple încălcări anterioare. Acest scor de reputație creează stimulente pentru conformitatea pe termen lung, dezavantajând potențial noii streameri care învață normele platformei.

Terminologia de Jocuri Care Poate Declanșa Avertismente

Limbajul competitiv de jocuri include numeroase fraze care seamănă cu conținutul interzis atunci când sunt scoase din contextul jocurilor. Fiți precauți cu:

- Referințe la ucideri (folosiți eliminări sau înfrângeri)

- Distrugerea adversarilor (folosiți depășirea sau câștigarea împotriva)

- Discuții jignitoare care trec în atacuri personale

- Expresii de furie care conțin blasfemii

- Limbajul de coordonare a echipei care seamănă cu planificarea violenței

- Sărbătorile victoriei care batjocoresc adversarii învinși

Streamerii de jocuri de tip first-person shooter și battle royale se confruntă cu provocări deosebite din cauza mecanicii de joc inerente violente. Menținerea unui context de joc clar prin terminologie consistentă specifică jocului și evitarea tranzițiilor la discuții despre violența din lumea reală minimizează riscurile de falsuri pozitive.

Streamerii de jocuri de strategie care discută despre **expansiune agresivă,**preluări ostile sau zdrobirea inamicilor ar trebui să mențină un cadru clar specific jocului pentru a preveni confuzia contextuală. Utilizarea terminologiei specifice jocului, mai degrabă decât a limbajului violent generic, ajută algoritmii să clasifice corect conținutul.

Ce Se Întâmplă De Fapt În Timpul Unei Mutări de 10 Minute

Înțelegerea impactului practic al auto-mutărilor îi ajută pe streameri să pregătească răspunsuri de urgență și să minimizeze perturbarea publicului atunci când apar încălcări.

Capacitățile și Restricțiile Streamerului în Timp ce Este Mutat

În timpul mutărilor active, microfonul tău se dezactivează automat, împiedicând transmiterea audio către spectatori. Capacitățile de chat text se suspendă, de asemenea, blocând comunicarea prin mesaje scrise. Cu toate acestea, videoclipul continuă să transmită normal, permițând spectatorilor să vadă reacții și conținut vizual.

Îți păstrezi accesul la controalele streamului, inclusiv la încheierea transmisiunilor, ajustarea setărilor camerei și vizualizarea mesajelor primite de la spectatori. Această funcționalitate parțială permite controlul daunelor prin comunicare vizuală – ținând semne, folosind gesturi sau afișând grafice pre-pregătite care explică dificultățile tehnice.

Notificarea de mutare apare doar pe tabloul tău de bord de streamer, nu și pentru spectatori. Publicul vede o pierdere bruscă a sunetului fără explicații, cu excepția cazului în care ai pregătit metode de comunicare vizuală. Mulți spectatori presupun dificultăți tehnice, mai degrabă decât încălcări ale politicilor, oferind o anumită protecție a reputației pentru infracțiunile accidentale.

Cum Experimentează Spectatorii Streamul Tău Mutat

Spectatorii experimentează o întrerupere bruscă a sunetului în mijlocul unei propoziții atunci când auto-mutările se activează, însoțită de obicei de confuzie cu privire la dacă problema provine de la dispozitivul lor, conexiune sau streamul tău. Fără notificări vizibile de mutare, publicul reîmprospătează adesea streamurile, verifică setările audio sau lasă comentarii întrebând despre probleme tehnice.

Videoclipul continuă normal, creând o disonanță între conținutul vizual care te arată vorbind și sunetul absent. Spectatorii implicați pot aștepta câteva minute așteptând rezolvarea, în timp ce spectatorii ocazionali ies de obicei pentru a găsi streamuri funcționale. Această pierdere de spectatori afectează numărul de spectatori concurenți, metricile de implicare și clasamentele de vizibilitate algoritmică.

Comentariile spectatorilor în timpul mutărilor includ adesea sugestii de depanare tehnică, întrebări despre probleme audio și, în cele din urmă, speculații despre încălcări ale politicilor. Utilizatorii Likee experimentați, familiarizați cu sistemele de auto-mutare, pot informa alți spectatori despre cauza probabilă, deteriorând potențial reputația chiar și pentru încălcări accidentale.

Impactul Asupra Metricilor Streamului și Clasamentelor de Vizibilitate

Auto-mutările declanșează o degradare imediată a metricilor pe măsură ce spectatorii confuzi ies. Numărul de spectatori concurenți scade brusc, ratele de finalizare a vizionării scad, iar metricile de implicare suferă din cauza incapacității de a răspunde la comentarii. Aceste impacturi asupra metricilor se extind dincolo de durata mutării de 10 minute, afectând recomandările algoritmice pentru ore sau zile după aceea.

Algoritmul de recomandare al Likee prioritizează streamurile cu metrici de implicare puternice, retenție consistentă a spectatorilor și interacțiuni pozitive cu publicul. Căderile bruște ale metricilor în timpul mutărilor semnalează probleme de calitate algoritmului, reducând vizibilitatea streamului în funcțiile de descoperire, fluxurile de recomandare și categoriile în tendințe.

Mutările multiple în intervale scurte de timp agravează daunele metricilor, construind în același timp istorice de încălcări care influențează deciziile viitoare de aplicare. Sistemul urmărește frecvența, gravitatea și modelele de încălcare pentru a identifica infractorii recidiviști care necesită penalități escalate. Trei sau mai multe mutări într-un singur stream declanșează adesea o revizuire manuală pentru potențiale interdicții temporare sau permanente.

Declanșatorii shadowban-ului se conectează, de asemenea, la degradarea metricilor legate de mutare. Streamurile care primesc mai puțin de 41 de aprecieri în 10 minute, zero vizualizări sau rate de finalizare a vizionării sub 80% se confruntă cu penalități de shadowban care suprimă vizibilitatea fără notificare. Auto-mutările care îți prăbușesc metricile pot declanșa din greșeală aceste penalități secundare, creând efecte de aplicare compuse.

14 Strategii Dovedite pentru a Evita Auto-Mutările pe Streamurile Likee

Strategiile proactive de conformitate minimizează riscurile de încălcare, menținând în același timp un conținut captivant și autentic care rezonează cu publicul.

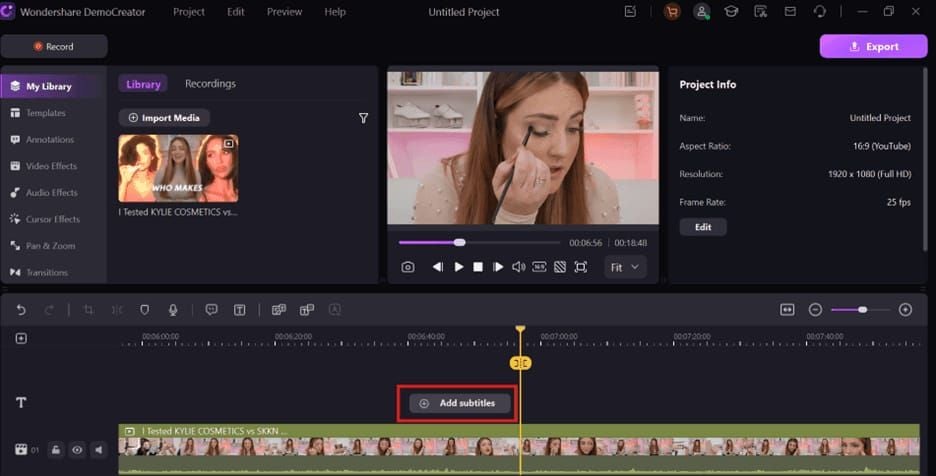

Pregătirea Pre-Stream: Configurarea Filtrelor de Chat

Configurează filtrele de chat încorporate ale Likee înainte de a intra live pentru a bloca automat cuvintele interzise din comentariile spectatorilor. Acest lucru previne citirea și repetarea accidentală a termenilor semnalați în timpul segmentelor de interacțiune cu spectatorii. Accesează setările filtrelor prin tabloul tău de bord de streamer, sub instrumentele de moderare.

Creează liste personalizate de cuvinte interzise specifice nișei tale de conținut și demografiei publicului. Streamerii de jocuri ar trebui să includă discuții jignitoare competitive care depășesc limitele hărțuirii, în timp ce streamerii de stil de viață s-ar putea concentra pe insultele bazate pe aspect și limbajul de body-shaming.

Testează configurațiile filtrelor în timpul streamurilor private pentru a te asigura că blochează termenii intenționați fără a crea falsuri pozitive excesive care frustrează comunicarea legitimă a spectatorilor. Echilibrează protecția împotriva supra-moderării care înăbușă implicarea publicului.

Tehnici de Monitorizare în Timp Real

Desemnează un moderator de încredere care să-ți monitorizeze streamul cu o întârziere de 10-15 secunde, oferind avertismente în timp real atunci când limbajul se apropie de limitele încălcării. Această perspectivă externă surprinde fraze riscante pe care le-ai putea rata în timpul transmisiunilor cu energie ridicată.

Folosește dispozitive secundare pentru a-ți monitoriza propriul stream așa cum îl experimentează spectatorii, ajutând la prinderea problemelor audio, a problemelor de context sau a limbajului de graniță înainte de a apărea încălcări. Această abordare cu două ecrane oferă feedback imediat despre modul în care conținutul se traduce în experiența publicului.

Dezvoltă o conștientizare personală a momentelor cu risc ridicat:

- Secvențe de jocuri competitive aprinse

- Discuții despre subiecte controversate

- Sesiuni de întrebări și răspunsuri cu spectatori cu întrebări imprevizibile

- Streamuri de colaborare cu invitați nefamiliarizați cu politicile Likee

- Streamuri de noapte târzie când oboseala reduce auto-monitorizarea

Antrenarea Publicului Tău cu Privire la Ghidurile Comunității

Educează spectatorii despre standardele comunității Likee în timpul introducerilor streamului, în special atunci când atragi public nou, nefamiliarizat cu regulile platformei. Explică faptul că anumite declanșatoare de limbaj aplică automat legea, afectând experiența tuturor, creând o responsabilitate comună pentru conformitate.

Fixează mesaje în chat care le reamintesc spectatorilor despre conținutul interzis și le cer să ajute la menținerea unor medii conforme. Încadrează ghidurile pozitiv ca valori comunitare, mai degrabă decât reguli restrictive, promovând o cultură de conformitate colaborativă.

Recunoaște și mulțumește spectatorilor care ajută la moderarea chatului raportând încălcări sau reamintind altora despre ghiduri. Această întărire pozitivă încurajează auto-disciplina comunității, reducând povara moderării tale și construind implicarea publicului în succesul streamului.

Utilizarea Eficientă a Instrumentelor de Moderare

Desemnează mai mulți moderatori de încredere în diferite fusuri orare pentru a asigura acoperirea în timpul tuturor orelor de streaming. Oferă ghiduri clare despre când să ștergi mesaje, să blochezi temporar utilizatori sau să te alertezi cu privire la potențiale încălcări care necesită un răspuns imediat.

Acordă moderatorilor permisiuni adecvate, inclusiv ștergerea mesajelor, blocarea temporară a utilizatorilor și capacități de interdicție pentru încălcări grave sau repetate. Cu toate acestea, rezervă-ți autoritatea de interdicție permanentă pentru tine, pentru a preveni abuzul moderatorilor sau aplicarea excesiv de zel.

Organizează sesiuni regulate de instruire a moderatorilor, revizuind actualizările recente ale politicilor, discutând scenarii dificile de moderare și aliniindu-te la standardele de aplicare. Moderarea consecventă creează medii previzibile în care spectatorii înțeleg limitele și consecințele.

Fraze Alternative pentru Cuvinte Comune Riscante

Dezvoltă substituții de vocabular pentru termenii cu risc ridicat, comuni în nișa ta de conținut:

În loc de blasfemie:

- La naiba sau fir-ar înlocuind cuvinte vulgare mai puternice

- Doamne ferește în loc de blasfemie religioasă

- Ce naiba pentru reacții surprinse

- Al naibii ca modificator de intensitate

În loc de limbaj violent de jocuri:

- Eliminat în loc de ucis

- Învins în loc de distrus

- Depășit înlocuind dominat

- Asigurat victoria versus zdrobit

În loc de argou potențial ofensator:

- Limbaj descriptiv specific înlocuind insultele vagi

- Terminologie specifică jocului în loc de discuții jignitoare generice

- Încadrare pozitivă care subliniază abilitatea ta față de slăbiciunea adversarului

Practică aceste substituții până când devin modele de vorbire naturale, reducând sarcina cognitivă în timpul momentelor de streaming cu energie ridicată, când auto-monitorizarea se dovedește cea mai dificilă.

Concepții Greșite Comune Despre Interdicțiile de Stream Likee

Clarificarea neînțelegerilor larg răspândite îi ajută pe streameri să ia decizii informate de conformitate bazate pe cunoștințe precise ale platformei, mai degrabă decât pe mituri comunitare.

Mit: Utilizarea Simbolurilor pentru a Înlocui Literele Ocolește Detectarea

AI recunoaște substituțiile comune de simboluri, inclusiv asteriscuri, numere și caractere speciale care înlocuiesc literele în cuvintele interzise. Modele precum **f*ck,****sh!t,**a$$, sau b!tch declanșează o aplicare identică cu termenii nemodificați. Algoritmii de potrivire a modelelor ai sistemului identifică similaritățile fonetice și tehnicile comune de evaziune.

Variațiile avansate care utilizează caractere Unicode, combinații de emoji sau spațiere creativă se confruntă, de asemenea, cu detectarea. Tehnologia se actualizează continuu pentru a recunoaște modelele emergente de evaziune pe măsură ce streamerii dezvoltă noi încercări de ocolire. Bazarea pe substituția simbolurilor creează o falsă securitate, rezultând adesea în încălcări neașteptate.

Singura abordare fiabilă implică eliminarea completă a termenilor interziși, mai degrabă decât încercarea de deghizări creative. Substituția vocabularului cu cuvinte cu adevărat diferite oferă o protecție reală versus modificările cosmetice ale limbajului semnalat.

Mit: Vorbirea Rapidă Previne Recunoașterea AI

Procesarea vorbirii în text gestionează diverse viteze de vorbire cu o precizie consistentă. Vorbirea rapidă poate introduce erori minore de transcriere, dar cuvintele interzise rămân recognoscibile chiar și cu o transcriere imperfectă. Toleranța la erori a AI ține cont de mormăit, accente și variații de viteză.

Vorbirea rapidă în timp ce se folosește limbaj interzis agravează adesea încălcările, apărând ca o evaziune intenționată. Sistemul poate interpreta blasfemia rapidă ca o eludare deliberată a politicii, declanșând potențial o revizuire manuală și penalități escalate dincolo de auto-mutările standard.

Vorbirea clară, cu un ritm moderat, oferă o protecție mai bună, asigurând o transcriere precisă a limbajului acceptabil. Când AI recunoaște cu încredere conținutul conform, este mai puțin probabil să semnaleze fraze de graniță care ar putea declanșa aplicarea legii în condiții de transcriere incerte.

Mit: Streamurile Private Nu Au Moderare

Toate streamurile Likee sunt supuse unei moderări automate identice, indiferent de setările de confidențialitate sau numărul de spectatori. Streamurile private limitate la urmăritori aprobați se confruntă cu aceeași detectare AI, praguri de aplicare și structuri de penalizare ca și transmisiunile publice. Auto-mutarea de 10 minute se activează identic, indiferent dacă se transmite la 5 spectatori sau 5.000.

Această aplicare universală împiedică streamerii să utilizeze streamurile private pentru a coordona încălcări, a partaja conținut interzis cu public select sau a practica conținut care încalcă politicile. Sistemul nu face distincție între contextele publice și private atunci când evaluează conformitatea cu ghidurile comunității.

Istoricele de încălcări din streamurile private afectează, de asemenea, statutul contului identic cu infracțiunile din streamurile publice. Încălcările multiple din streamurile private contribuie la modele de escaladare care declanșează revizuiri manuale și potențiale interdicții permanente.

Adevăr: Cum Încălcările Repetate Escalatează Penalitățile

Platforma urmărește frecvența, gravitatea și modelele de încălcare în istoricul de streaming. În timp ce auto-mutările individuale durează exact 10 minute, indiferent de numărul de încălcări, infracțiunile acumulate declanșează consecințe escalate, inclusiv revizuiri manuale, suspendări temporare și interdicții permanente.

Pragurile specifice de escaladare rămân nedezvăluite pentru a preveni manipularea sistemului, dar streamerii raportează revizuiri manuale după 3-5 încălcări în perioade de 30 de zile. Aceste revizuiri evaluează dacă încălcările reprezintă infracțiuni accidentale sau ignorarea intenționată a politicii, determinând penalitățile escalate adecvate.

Interdicțiile permanente care durează 1-20 de ani devin posibile după stabilirea unor modele de încălcări repetate, în ciuda avertismentelor anterioare. Cele mai severe interdicții de 20 de ani se aplică de obicei încălcărilor flagrante, cum ar fi streamingul de către minori, discursul instigator la ură sever sau campaniile de hărțuire coordonate. Procesele de apel pentru interdicțiile permanente costă 175 USD, cu o procesare de 24-48 de ore și necesită documentație completă, inclusiv verificare a vârstei, scrisori de scuze și angajamente de conformitate.

Procesul de Recuperare și Apel După Primirea Mutărilor

Înțelegerea procedurilor post-încălcare îi ajută pe streameri să minimizeze daunele pe termen lung și să restabilească statutul contului după infracțiuni.

Cum Afectează Mutările Multiple Statutul Contului Tău

Fiecare auto-mutare creează o înregistrare permanentă în istoricul contului, contribuind la analiza modelelor de încălcare care influențează deciziile viitoare de aplicare. Sistemul cântărește încălcările recente mai mult decât infracțiunile istorice, încălcările mai vechi de 90 de zile având un impact redus asupra statutului curent.

Densitatea încălcărilor contează mai mult decât numărul absolut. Cinci încălcări răspândite pe șase luni primesc un tratament diferit față de cinci încălcări într-o săptămână. Modelele concentrate de încălcare sugerează ignorarea intenționată a politicii sau eforturi inadecvate de conformitate, declanșând răspunsuri de aplicare mai agresive.

Impactul statutului contului se extinde dincolo de aplicare:

- Vizibilitate redusă în algoritmii de recomandare

- Prioritate mai mică în funcțiile de descoperire

- Eligibilitate redusă pentru promoțiile platformei

- Excludere potențială din programele de monetizare

- Credibilitate redusă în oportunitățile de parteneriat

Ghid Pas cu Pas pentru Apelarea Auto-Mutărilor Greșite

În timp ce auto-mutările de 10 minute se rezolvă automat fără a necesita apeluri, documentarea aplicării greșite ajută la stabilirea modelelor pentru apeluri escalate dacă încălcările se acumulează:

- Înregistrează imediat ora și contextul încălcării - Notează exact ce ai spus, conversația înconjurătoare și de ce crezi că aplicarea legii a fost eronată

- Capturează dovezi video, dacă este posibil - Înregistrările de ecran care arată momentul încălcării oferă dovezi concrete pentru revizuirile apelurilor

- Documentează notificarea de auto-mutare - Fă o captură de ecran a tabloului de bord al streamerului care arată acțiunea de aplicare și motivul declarat

- Revizuiește încălcarea reală în raport cu ghidurile comunității - Evaluează sincer dacă conținutul a încălcat cu adevărat politicile versus reprezentând o eroare algoritmică

- Trimite apeluri detaliate la feedback@likee.video - Include orele, explicațiile contextului, dovezile video și interpretările specifice ale politicii care susțin poziția ta

- Menține conformitatea în timpul procesării apelului - Încălcările suplimentare în timpul revizuirilor apelurilor dăunează grav credibilității și reduc probabilitatea de anulare

Procesarea apelurilor pentru penalități grave durează 24-48 de ore, cu costuri variind de la 125 USD pentru interdicțiile temporare la 175 USD pentru apelurile de interdicție permanentă. Apelurile pentru shadowban costă 145 USD. Cu toate acestea, auto-mutările individuale de 10 minute nu justifică de obicei apeluri plătite, cu excepția cazului în care contribuie la penalități escalate.

Restaurarea Scorului de Reputație al Streamerului Tău

Conformitatea consecventă pe perioade extinse restabilește treptat statutul contului deteriorat de încălcările anterioare. Algoritmii de reputație ai platformei cântăresc comportamentul recent mai mult, permițând streamerilor să-și revină din greșelile timpurii prin aderarea susținută la politici.

Strategii de restaurare:

- Menține streamingul fără încălcări timp de 90+ zile consecutive

- Generează metrici puternice de implicare pozitivă care semnalează conținut de calitate

- Construiește comunități de public cu cerințe scăzute de moderare

- Participă la inițiativele platformei și la programele pentru creatori

- Demonstrează cunoștințe de politică prin leadership comunitar

Educația proactivă privind conformitatea semnalează angajamentul față de standardele platformei. Streamerii care discută public ghidurile comunității, îi ajută pe alți creatori să înțeleagă politicile și promovează culturi comunitare pozitive primesc beneficii algoritmice care compensează parțial impactul încălcărilor istorice.

Ia în considerare pauze temporare de streaming după multiple încălcări pentru a reseta modelele și a aborda conținutul cu un accent reînnoit pe conformitate. Continuarea streamingului în timp ce ești frustrat de aplicarea legii generează adesea încălcări suplimentare care agravează daunele reputației.

Întrebări Frecvente

Ce cuvinte declanșează mutări automate pe streamurile live Likee?

AI-ul Likee semnalează blasfemia, discursul instigator la ură, termenii discriminatorii, frazele de hărțuire, referințele la conținut pentru adulți, limbajul violent și mențiunile de activitate ilegală. Sistemul menține baze de date cu sute de cuvinte interzise specifice în mai multe limbi, cu analiza contextului care determină dacă termenii de graniță încalcă politicile. Variațiile creative de scriere care utilizează simboluri sau numere primesc o aplicare identică cu cuvintele interzise nemodificate.

Cât durează o mutare de stream Likee?

Auto-mutările durează exact 10 minute de la activare. Microfonul și capacitățile tale de chat se dezactivează automat, în timp ce videoclipul continuă să transmită normal. Mutarea se rezolvă automat fără a necesita apeluri sau intervenție manuală. Cu toate acestea, mutările multiple în intervale scurte de timp declanșează revizuiri manuale care pot duce la suspendări temporare sau interdicții permanente care durează 1-20 de ani.

Poți apela o penalizare de auto-mutare Likee?

Auto-mutările individuale de 10 minute nu necesită apeluri, deoarece se rezolvă automat. Cu toate acestea, dacă încălcările acumulate declanșează penalități escalate, cum ar fi interdicții temporare sau permanente, poți apela prin feedback@likee.video. Apelurile pentru interdicții temporare costă 125 USD, apelurile pentru interdicții permanente costă 175 USD, iar apelurile pentru shadowban costă 145 USD. Procesarea durează 24-48 de ore și necesită documente de verificare a vârstei, scrisori de scuze și angajamente de conformitate.

Te interzice Likee permanent pentru că spui cuvinte urâte?

Încălcările unice de blasfemie declanșează auto-mutări de 10 minute, mai degrabă decât interdicții permanente. Cu toate acestea, încălcările repetate stabilesc modele care escaladează la suspendări temporare și, în cele din urmă, la interdicții permanente care durează 1-20 de ani. Platforma a emis 42.751 de interdicții între ianuarie și mai 2021, cele mai severe interdicții de 20 de ani fiind de obicei rezervate încălcărilor flagrante, cum ar fi streamingul de către minori, discursul instigator la ură sever sau campaniile de hărțuire coordonate.

Cum detectează Likee cuvintele interzise în timp real?

AI-ul Likee convertește vorbirea în text continuu în timpul transmisiunilor, analizând modele fonetice, utilizarea contextuală și semnificația semantică. Sistemul semnalează încălcările în 10 minute de la apariție, procesând de obicei vorbirea în 2-3 secunde de la rostire. Suportul multilingv, detectarea argoului și analiza contextului ajută la diferențierea utilizării interzise de mențiunile acceptabile, deși algoritmii imperfecți generează ocazional falsuri pozitive.

Ce se întâmplă cu spectatorii când un streamer este mutat?

Spectatorii experimentează o întrerupere bruscă a sunetului fără notificări vizibile care să explice cauza. Videoclipul continuă să transmită normal, creând confuzie, deoarece te văd vorbind fără a auzi sunet. Majoritatea spectatorilor presupun dificultăți tehnice, mulți reîmprospătând streamurile sau verificând setările audio. Aproximativ 30-50% dintre spectatori ies de obicei din streamurile mutate în 2-3 minute, afectând semnificativ metricile de implicare și clasamentele de vizibilitate algoritmică.

Menține-ți cariera de streamer Likee înfloritoare! Reîncarcă-ți diamantele Likee în siguranță și instantaneu la BitTopup pentru a debloca funcții premium, a crește vizibilitatea și a-ți implica publicul fără întreruperi. Vizitează BitTopup acum pentru oferte exclusive la reîncărcările Likee!